L’avvento inevitabile dell’intelligenza artificiale nella gestione dell’infrastruttura dei data center

Mantenere un data center non è affatto semplice. Chiunque si sia occupato di garantire il funzionamento continuo dell’infrastruttura cercando al contempo di ridurre le spese operative sa benissimo di cosa parliamo.

Mantenere inalterata l’operatività è un gioco da ragazzi quando si hanno risorse illimitate. Basta usare una configurazione 3N+1 o migliore per azzerare (o quasi) le possibilità di interruzioni.

Detto ciò, nessuno sarebbe in grado di accollarsi spese del genere: né in termini di investimento, né tanto meno per via dei costi operativi necessari a garantire il funzionamento di tutte quelle apparecchiature.

Una via di mezzo

Spetta al responsabile operativo di un data center il difficile compito di trovare il giusto compromesso tra l’operatività e la somma di CapEx e OpEx. Come si ottiene la massima operatività con un investimento minimo e i costi operativi più bassi possibile? A volte esistono massimali fissi di operatività da cui calcolare i costi, ad esempio 99,995%. In altri casi, invece, occorre individuare la massima operatività che è possibile ottenere con un costo specifico. A prescindere, il responsabile operativo si ritrova davanti un campo minato di opzioni, dove ogni decisione influisce su altre variabili. Un po’ come una partita di scacchi, dove si gioca d’anticipo.

L’intelligenza artificiale stravince sugli esseri umani

Nel 1996 fu la volta del computer IBM Deep Blue, che batté il campione del mondo in carica Garry Kasparov 3,5 a 2,5 in un torneo di scacchi. Nel 2017, l’intelligenza artificiale AlphaGo sconfisse l’allora giocatore numero uno al mondo Ke Jie aggiudicandosi 3 partite su 3 di Go, un gioco ben più complesso degli scacchi. Più e più volte, le intelligenze artificiali si sono rivelate migliori degli esseri umani nel prendere decisioni strategiche. Pertanto, è naturale che coadiuvino il processo decisionale di un data center.

Far funzionare un data center è una passeggiata, no?

In un data center esistono tutta una serie di varianti interconnesse: ad esempio, la temperatura dell’aria nei locali dei server, la temperatura in ingresso e in uscita dell’impianto di condizionamento, la velocità dell’aria, i livelli di efficienza dei vari dispositivi infrastrutturali. Per non parlare poi del fabbisogno energetico dei server, che oscilla di continuo. Per alcuni cluster i consumi massimi si verificano di notte, mentre altri sono più attivi durante l’orario di ufficio.

Nel mentre ci si destreggia tra questi parametri, bisogna contemporaneamente tenere d’occhio anche la ridondanza di tutte le apparecchiature, per evitare che un solo guasto causi interruzioni. E anche a patto di essersela cavata egregiamente finora, occorre ricordarsi di eseguire la manutenzione di tutto l’hardware installato ed evitare cali della ridondanza durante questa attività. Il tutto, ovviamente, con il minimo dispendio energetico possibile.

Non ci sono dubbi: per gli esseri umani è quasi impossibile. Le macchine, invece, riescono a fare calcoli infinitamente più veloci.

Contano solo i calcoli?

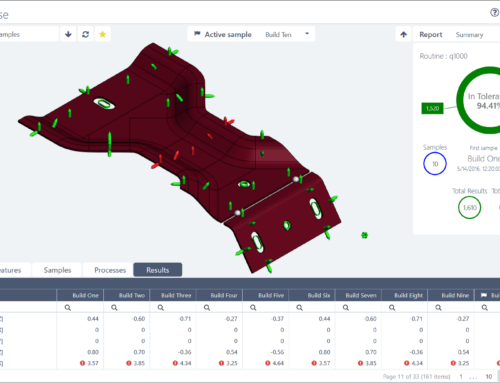

No, perché un computer non pensa autonomamente e calcola soltanto le informazioni tradotte in codice. Il deep learning o apprendimento approfondito consente ai computer di analizzare enormi quantità di dati e trarne conclusioni. Anche questo, però, ha dei limiti: come ci si comporta in situazioni inedite? Come si può prevedere qualcosa di non ancora testato? Ed è lì che subentra il concetto di “Digital Twin”, una tecnologia a cui si affida Perf-iT nell’ultima versione di 4D Cool, un concetto innovativo per la gestione dell’efficienza dei data center.

Digital Twin e scenari ipotetici

4D Cool è un sistema di gestione basato su dati reali e generati da quantità limitate di sensori: si serve della fluidodinamica computazionale (CFD) per prevedere la temperatura nei vari angoli dalla data room e creare una versione interamente digitale del data center. Il sistema, poi, migliora di continuo i suoi pronostici grazie all’analisi dei risultati della CFD e ai dati reali dei sensori. Raggiunge così un livello di attendibilità sufficientemente elevato da analizzare situazioni ipotetiche, ad esempio cosa succederebbe se uno dei trasformatori si rompesse o se aggiungessimo altri 500 server a questa corsia. Queste situazioni ipotetiche si possono calcolare soltanto nel modello di Digital Twin poiché, di fatto, è una copia esatta del data center reale.

Il futuro dei data center è digitale

I data center diventano sempre più grandi e complessi. Nessuno è in grado di gestire contemporaneamente una quantità così elevata di variabili e prevedere gli effetti di eventuali modifiche a più variabili. Occorre affidarsi ai computer. Da soli, però, i calcoli non bastano. Il computer deve poter verificare i suoi calcoli tramite analisi comparate su dati reali. Il Digital Twin offre proprio questa possibilità. Adesso il responsabile del data center dispone di uno strumento con cui analizzare quali conseguenze causano determinate modifiche al data center, così da scegliere come meglio agire. Questo strumento è 4D Cool e non vediamo l’ora di dimostrare le sue potenzialità.

Parliamo dei vostri requisiti per un data center.

[contact-form-7 id=”87593″ title=”Contact Form – Blog Post”]